فناوری صدای جدیدی به ما میدهد؛ شکستن دیوارهای سکوت

وقتی این فیلم در سال ۱۹۶۸ منتشر شد، این ایده که کامپیوترها بتوانند گفتوگوی مناسبی با انسانها برقرار کنند، به اندازه سفر فضایی انسان به سیاره مشتری، بسیار دور از دسترس به نظر میرسید. سوال را نفهمیدم.» «هال، درهای دریچه را باز کن.» «لیستی از نتایج جستوجوی دریچه خدمت شما، دیو.»

هنوز راه زیادی داریم تا کامپیوترهای گویایی بسازیم که واقعاً بتوانند امر غیرمنتظره را مدیریت کنند. با این حال، درست است که تکنولوژی زبان آماده نیست جانشین انسان شود مگر در برخی کارهای بسیار ساده و روزمره اما همین تکنولوژی زبان به اندازهای خوب است که بالاخره میتوان آن را جدی گرفت.

تشخیص گفتار پیشرفتهای مثالزدنی داشته است. در نتیجه بودجه بیشتری به توسعه تکنولوژی زبان اختصاص پیدا کرد و این تکنولوژی، هرچند با سرعت کم، رو به پیشرفت است.

بسیاری از رویکردهای اولیه تکنولوژی زبان و بهویژه ترجمه در بنبست مفهومی گرفتار شدند: رویکرد مبتنی بر قوانین. اما هنوز کسی نمیداند چگونه باید از این حالت خوب به حالت عالی و قابل اعتماد حرکت کرد.

تشخیص گفتار: به تو گوش میدهم

وقتی فرد حرف میزند، هوا از ششهایش بیرون میآید و باعث میشود تارهای صوتی به ارتعاش دربیایند. قبلاً از فنون آماری استفاده میشد اما اخیراً یادگیری عمیق بیشتر در کانون توجه قرار گرفته است.

پیشرفت تکنولوژی نیز بهتدریج به رفع مشکلات تشخیص صوت کمک کرده است. حتی تلفنهای هوشمند نیز امروز از قدرت پردازش کافی برای انجام این تحلیل برخوردارند.

تفاوت الگوی زبان با واقعیت زبان

شاید مجموعه انتظارها مهمترین مشخصه سیستم تشخیص گفتار باشد. این حدس به نوع کلمات، عبارتها و دستور زبانی استوار است که سیستم قبلاً در متن آموزشی دریافت کرده است.

میتوان دادههایی را که بر اساس صدای کاربر تهیه شدهاند به کامپیوتر آموزش داد تا حدس زدن تسهیل شود. به همین دلیل است که مایکروسافت محصولی به نام CRIS ارائه کرده تا کاربران بتوانند سیستمهای تشخیص گفتار را بر اساس صدای پسزمینه، کلمات ویژه و سایر جزئیات در محیطهای خاص تنظیم کنند.

اما اینکه کامپیوتر بداند انسان چه گفته صرفاً شروع کار است. تعامل مناسب بین انسان و کامپیوتر به آن شکلی که در داستانهای علمی تخیلی نمایش داده میشود مستلزم این است که ماشینها بتوانند به حرف بیایند و جواب بدهند.

ترجمه ماشینی

ترجمه خودکار باکیفیت جادوییتر از سایر انواع تکنولوژی زبان به نظر میرسد زیرا بسیاری از انسانها تلاش میکنند بیش از یک زبان بدانند چه برسد از زبانی به زبان دیگر ترجمه کنند. این مفهوم به روزهای اول جنگ سرد برمیگردد؛ وقتی دانشمندان آمریکایی تلاش میکردند به کامپیوترها آموزش دهند متون روسی را ترجمه کنند.

دانشمندان از موفقیتهای رمزگشایی در جنگ جهانی دوم الهام گرفته بودند و همین تلاش برای شکستن کدها بود که به توسعه اولین کامپیوترها انجامید. از نظر این افراد، متن روسی در واقع نسخه رمزگذاریشده متن انگلیسی بود و تبدیل آن به انگلیسی صرفاً به معنی رمزگشایی بود.

دانشمندان در آیبیام و دانشگاه جرجتاون جزو آنهایی بودند که فکر میکردند این مشکل بهسرعت حل میشود؛ صرفاً برای شش قانون برنامهنویسی کردند و ۲۵۰ واژه به کامپیوتر معرفی کردند. یکی از دانشمندان جرجتاون تحت تاثیر این پیشرفت پیشبینی کرد ترجمه ماشینی در عرض سه تا پنج سال به حقیقت خواهد پیوست.

برعکس، کمی بیش از گذشت یک دهه از کار روی این موضوع، گزارش سال ۱۹۶۶ کمیته جان پیِرس نسبت به نتایج تحقیقات اعلام ناامیدی کرد و از محققان خواست بر اهداف کوچک و دستیاب مانند دیکشنریهای خودکار تمرکز کنند. راهحلش این بود که بهجای نوشتن برنامههای مبتنی بر قوانین، گفتار طبیعی برای آموزش دادن ماشین مورد استفاده قرار بگیرد.

دو دهه بعد، آیبیام به رویکردی رسید که خوشبینی درباره ترجمه ماشینی را احیا کرد. رویکرد آماری تضمین میکند کلمه بر اساس واژههای اطرافش ترجمه میشود.

اما کیفیت ترجمه وقتی جهش پیدا کرد که گوگل تصمیم گرفت کل اینترنت را ایندکس کند و از این دادهها برای آموزش دادن ماشینهای ترجمهاش کمک بگیرد. این الگو میتواند مجموعهای از ترجمهها در زبان مقصد را تسهیل کند.

کاربران اینترنت بهزودی کشف کردند گوگلترنسلیت بسیار بهتر از مترجمهای آنلاین مبتنی بر قوانین عمل میکند. گوگل حالا از ترجمه ماشینی مبتنی بر شبکه عصبی استفاده میکند تا برای هشت جفت زبان خدمات ترجمه ارائه دهد.

مترجمهای آینده احتمالاً متخصص کنترل کیفی خواهند بود و تصمیم خواهند گرفت کدام متنها با جزئیات بیشتری به توجه نیاز دارند. این کار شاید ضروری باشد زیرا کامپیوترها هر اندازه که باهوشتر شوند هنوز نمیتوانند معنای متن را واقعاً درک کنند.

معنا و هوش ماشین:

درباره چه حرف میزنید؟

ماشینها نمیتوانند گفتوگوی مناسبی با انسانها داشته باشند زیرا دنیا را درک نمیکنند.

در سریال «Black Mirror»، زنی جوان نامزدش را در تصادف خودرو از دست میدهد که کاربر فعال رسانههای اجتماعی بود. در غیر این صورت، کامپیوترها نمیتوانند درباره موضوعات متفاوت حرف بزنند، گفتوگوهای طولانی را دنبال یا غافلگیریها را مدیریت کنند.

البته ماشینهایی که آموزش میبینند کارهای محدودی انجام دهند، نتایج شگفتآوری رقم میزنند. مایکروسافت از گفتارهای محاوره در تعاملهای روزمره استفاده کرده تا به دستیار دیجیتالیاش کورتانا آموزش دهد.

با این اوصاف، پلتفرمهای زبان طبیعی از کجا میدانند مردم چه میخواهند؟ ماشینها نهتنها کلمات مورد استفاده افراد را تشخیص میدهند بلکه گفتار را برای تحلیل دستور زبان و معنی تجزیه میکنند. اما معنی تحت عنوان «درک زبان طبیعی» قرار میگیرد که بسیار دشوارتر است.

عقل سلیم حتی در میان انسانها هم به اندازه کافی رواج ندارد؛ برنامهنویسی برای ایجاد عقل سلیم در کامپیوترها جای خود دارد. برای مثال، گراف گوگل میداند جیکوب برنولی در دانشگاه بازل تحصیل کرده (مانند سایر افرادی که از طریق این گره در گراف به برنولی وصل میشوند) و کتاب «قانون اعداد بزرگ» (گوگل میداند این اسم یک کتاب است) را نوشته است.

سازماندهی اطلاعات به این شیوه برای شرکتی که دادههای زیاد و ظرفیتهای هوش مصنوعی مناسبی دارد دشوار نیست اما وصل کردن اطلاعات به زبان سخت است. سیستم واتسون آیبیام که در سال ۲۰۱۱ بر دو قهرمان در یک بازی رقابتی غلبه کرد، سازوکار سادهای داشت: محاسبه تعداد زیادی از پاسخهای احتمالی بر اساس کلمات کلیدی و احتمالات نه از طریق درک انسانی سوال.

محاسبهپذیر کردن اطلاعات دنیای واقعی چالشانگیز به نظر میرسد. این توانایی به سیستم زبان طبیعی اجازه میدهد تفاوت بین معناهای یک کلمه خاص را شناسایی کند.

گفتوگوی مناسب بین انسانها و ماشینها را میتوان مجموعهای از چالشهای بههمپیوسته تلقی کرد: تشخیص گفتار، گفتار مصنوعی، تحلیل جمله، تحلیل معنا، درک کاربردی، گفتوگو، عقل سلیم و دانش درباره دنیای واقعی. نوشتن برنامهای که کمک کند ماشین چنین عملکردی را تکرار کند هنوز در حال تکامل است.

نگاهی به آینده: شگرد بعدی من

امروز همه باید ماشینهای گویا داشته باشند.

در فیلم WALL-E، بعد از آنکه کل محیط زمین زیستناپذیر شده، همه انسانها روی یک فضاپیما زندگی میکنند. حتی در آینده خوشبینانهای مانند WALL-E که در آن ماشینها کارها را انجام میدهند، میتوان دید که غیابِ چالش به مردم آسیب میزند.

خوشبختانه کارهایی که ماشینهای گویا از لیست کارهای انسانها برمیدارند از آن کارهایی هستند که بسیاری از مردم با کمال میل واگذارشان میکنند. Jibo، یک «ربات اجتماعی» جدید، میخواهد برای بچهها داستان بگوید، به حفظ رابطه با وابستگان دور کمک کند و کارهایی از این دست.

جوامع کوچک از نظر زبانی نیز میتوانند از این تکنولوژی سود ببرند. شبکههای عصبی و سایر نرمافزارها این امکان را به وجود میآورند که نسخههای جدیدتر سرویسها سریعتر و کارآمدتر از همیشه تولید شوند.

دو نقطهضعف در گسترش تکنولوژی زبان طبیعی وجود دارد: پیامدها برای حریم و اختلال در بسیاری از مشاغل.

دستگاهها بیش از پیش در حال گوش دادناند. علاوه بر این، سرویسهای مکانمحور بسیاری از شرکتهای بزرگ مشغول حدس زدن نیازها و خواستههای کاربراناند.

موضوع نگرانکننده دیگر در مورد تکنولوژی زبان طبیعی به مشاغل برمیگردد. تکنولوژی زبان حالا به اندازه کافی بالغ شده و میتواند بسیاری از این کارها را انجام دهد.

انسانها در طول یک دوره طولانی تحول همچنان لازم خواهند بود اما کارهایشان کمتر روزمره خواهد بود. برت برانک، یکی از مدیران ارشد نوآنس، میگوید استفاده از حدود ۲۰۰ معیار برای شناسایی گوینده احتمالاً امنتر از اثرانگشت است.

کل این بحث سرانجام این سوال را به ذهن متبادر میکند که انسان بودن چه معنایی دارد. محققان هوش مصنوعی تاکید میکنند که ماشینها مثل مردم فکر نمیکنند اما اگر مثل انسانها گوش بدهند و حرف بزنند، آنها را چه میتوان نامید؟ اگر انسانها به ماشینهای قویتر بیشتر آموزش دهند تا از زبان استفاده کنند، مرز بین انسان و ماشین که زمانی برجسته بود کمرنگ خواهد شد.

منبع: اکونومیست

«متاسفم دیو! نمیتوانم این کار را بکنم.» هال ۹۰۰۰ (HAL 9000)، کامپیوتر فضاپیما در فیلم «۲۰۰۱: یک ادیسه فضایی»، از باز کردن درها به روی دیو بومن امتناع میکند. دیو فضانورد برای انجام ماموریتی از فضاپیما خارج شده بود. تصمیم هال ۹۰۰۰ برای اقدام علیه انسانی که همراهیاش میکرد موج وحشتی از کامپیوترهای هوشمند برانگیخت.

وقتی این فیلم در سال ۱۹۶۸ منتشر شد، این ایده که کامپیوترها بتوانند گفتوگوی مناسبی با انسانها برقرار کنند، به اندازه سفر فضایی انسان به سیاره مشتری، بسیار دور از دسترس به نظر میرسید. بشر در ادامه خوب پیشرفت کرد و ماشینهایی ساخت که میتوانند با چیزی که شبیه گفتار طبیعی است پاسخ دهند. با وجود این، برقرار کردن ارتباط هنوز هم دشوار است. اگر فیلم «۲۰۰۱: یک ادیسه فضایی» را دوباره میساختیم تا وضعیت امروز تکنولوژی زبان را نشان دهیم، گفتوگو چیزی شبیه این میشد: «هال، دریچه را باز کن.» «متاسفم دیو. سوال را نفهمیدم.» «هال، درهای دریچه را باز کن.» «لیستی از نتایج جستوجوی دریچه خدمت شما، دیو.»

هنوز راه زیادی داریم تا کامپیوترهای گویایی بسازیم که واقعاً بتوانند امر غیرمنتظره را مدیریت کنند. وقتی از دانشمندان هوش مصنوعی درباره آینده هال ۹۰۰۰ هوشمند و ترمیناتور سوال میکنیم، فقط میخندند. با این حال، درست است که تکنولوژی زبان آماده نیست جانشین انسان شود مگر در برخی کارهای بسیار ساده و روزمره اما همین تکنولوژی زبان به اندازهای خوب است که بالاخره میتوان آن را جدی گرفت.

تشخیص گفتار پیشرفتهای مثالزدنی داشته است. ترجمه ماشینی هم از وضعیت افتضاح درآمده و میتواند خلاصهای از نکات اصلی متن ارائه دهد. شاید بهزودی ترجمه صرفاً به ویرایش جزئی انسانها نیاز داشته باشد. دستیارهای شخصی کامپیوتری مانند سیری اپل، الکسای آمازون، Now گوگل و کورتانای مایکروسافت میتوانند انواع سوالها را دریافت کنند و پاسخهایی مفید و صحیح با صوت طبیعی ارائه دهند. الکسا حتی میتواند به درخواست «برایم جوک تعریف کن» هم پاسخ دهد؛ البته با استفاده از پایگاهدادهای از شوخیهای دمدستی. کامپیوترها درکی از طنز ندارند.

محققان درباره مجموعه مشترکی از راهکارها اتفاق نظر دارند. این راهکارها برای آموزش کامپیوترها در زمینههای تشخیص صوت، شناسایی گوینده، تحلیل احساسات متنها، تجزیهوتحلیل دستور زبان، شناسایی زبان، تشخیص دستخط یا کارهای دیگر استفاده میشوند. محققان شاخصهای مد نظر برای بهبود را تعیین میکنند، مجموعه دادههای مورد نیاز برای آموزش به نرمافزارشان را به کامپیوتر میدهند و اجازه میدهند افراد بیطرف نتایج را آزمون کنند. فرایند این کار باعث میشود شفافیت بسیار بیشتر شود. در نتیجه بودجه بیشتری به توسعه تکنولوژی زبان اختصاص پیدا کرد و این تکنولوژی، هرچند با سرعت کم، رو به پیشرفت است.

بسیاری از رویکردهای اولیه تکنولوژی زبان و بهویژه ترجمه در بنبست مفهومی گرفتار شدند: رویکرد مبتنی بر قوانین. این در ترجمه یعنی نوشتن قوانین برای تحلیل متن در زبان مبدأ، تجزیه زبان و تبدیل آن به «زبان مشترک» انتزاعی و بازسازی آن بر اساس قوانین زبان مقصد. این رویکرد ابتدا نویدبخش بود اما بهزودی وقتی در جملههای پیچیده به کار رفت شکست خورد. تقریباً کل تکنولوژی زبان در زمینه روشهای آماری بهتر شده است. این روشهای آماری را رویکرد «بروت فورس» (تحتاللفظی «زور بیقاعده») نیز مینامند. این کار با جستوجوی مقادیر عظیم داده همراه است.

هدف شناسایی الگوها و یادگیری از سوابق است. نرمافزار تشخیص صوت، مجموعهای از اصوات ضبطشده را یاد میگیرد. افزایش قدرت پردازندهها به همراه انفجار دادهها در نهایت تکنولوژی زبان را پیش میبرند. امروز افرادی که قبلاً از ترجمههای ماشینی ناراضی بودند به گوگلترنسلیت اعتماد میکنند. اپل میلیونها نفر را متقاعد کرده تا با تلفنهایشان حرف بزنند. یادگیری عمیق که از طریق شبکههای عصبی دیجیتالی امکانپذیر شده، این پیشرفت را دوچندان میکند. در حالت کلی، تکنولوژی زبان که ابتدا بیمصرف بود امروز بهنسبت خوب است. اما هنوز کسی نمیداند چگونه باید از این حالت خوب به حالت عالی و قابل اعتماد حرکت کرد.

تشخیص گفتار: به تو گوش میدهم

وقتی فرد حرف میزند، هوا از ششهایش بیرون میآید و باعث میشود تارهای صوتی به ارتعاش دربیایند. این ارتعاش باعث انتشار امواجی با الگوی خاص در هوا میشود. در سطح نظریه، تبدیل کردن این جریان صوتی به گفتار پیادهشده روی متن باید ساده باشد. ماشینهایی که گفتار را تشخیص میدهند بر اساس دادههایی که قبلاً جمعآوری شدهاند آموزش میبینند. در این زمینه، دادههای آموزشی اصوات ضبطشدهای هستند که انسانها به متن تبدیلشان کردهاند تا نرمافزار صدا و ورودی متن را همزمان دریافت کند. قبلاً از فنون آماری استفاده میشد اما اخیراً یادگیری عمیق بیشتر در کانون توجه قرار گرفته است.

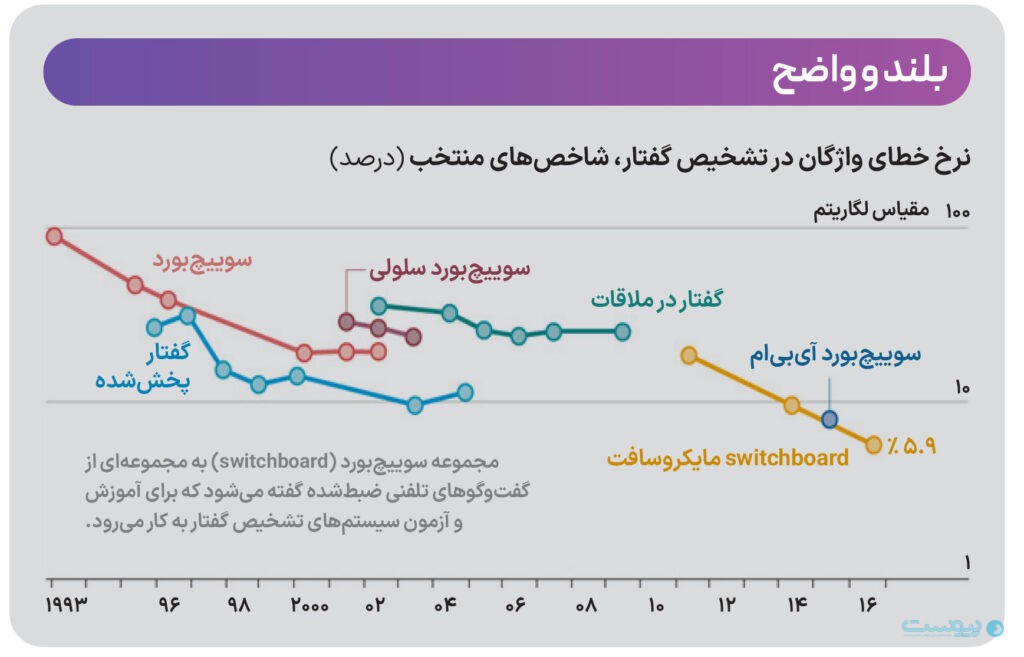

پیشرفت تکنولوژی نیز بهتدریج به رفع مشکلات تشخیص صوت کمک کرده است. نرخ خطا در نرمافزارهای تشخیص صوت در طول سالهای اخیر با شیب ملایم کاهش یافت اما ناگهان یادگیری عمیق باعث شد نرخ خطا با شیب تندی کاهش یابد. دلیلش را میتوان در وفور دادهها جستوجو کرد. اینترنت بیسیم بسیار فراگیر است و این موضوع باعث تولید انبوه گفتارهای ضبطشده میشود. این گفتارها به کامپیوترهای ابر ارسال میشوند تا در دست تحلیل قرار بگیرند. حتی تلفنهای هوشمند نیز امروز از قدرت پردازش کافی برای انجام این تحلیل برخوردارند.

تفاوت الگوی زبان با واقعیت زبان

شاید مجموعه انتظارها مهمترین مشخصه سیستم تشخیص گفتار باشد. این انتظارها نشان میدهند فرد احتمالاً چه میگوید. این انتظارها را «الگوی زبانی» مینامیم. الگوهای زبانی مانند سایر دادههای آموزشی بر مقادیر عظیمی از گفتار واقعی انسان استوارند و به متن تبدیل شدهاند. وقتی سیستم تشخیص گفتار جریانی از اصوات را «بشنود»، حدس میزند تا ببیند چه گفته شده. سپس احتمال حدس صحیح را محاسبه میکند. این حدس به نوع کلمات، عبارتها و دستور زبانی استوار است که سیستم قبلاً در متن آموزشی دریافت کرده است.

میتوان دادههایی را که بر اساس صدای کاربر تهیه شدهاند به کامپیوتر آموزش داد تا حدس زدن تسهیل شود. چند دقیقه خواندن متن آموزشی برای نرمافزاری مانند درگن دیکتیت میتواند سطح دقت را بهشدت افزایش دهد. برای افرادی که حاضر باشند نرمافزار را مدت طولانیتری آموزش دهند، درستی حدسها به چیزی نزدیک ۹۹ درصد میرسد. یک میکروفن خوب و یک اتاق ساکت کافی است.

از طرف دیگر، یادگیری عمیق نرخ خطاها را تا حدود زیادی پایین آورده است. مایکروسافت در ماه اکتبر اعلام کرد جدیدترین سیستم تشخیص صوتش عملکردی برابر با عملکرد انسان دارد. ۱۵ سال قبل، کیفیت پیشرفتی نداشت و نرخ خطای واژگان به ۲۰ تا ۳۰ درصد میرسید اما حالا جدیدترین سیستم مایکروسافت که از شش شبکه عصبی موازی استفاده میکند، به نرخ خطای ۵.۹ درصد رسیده است (برابر با نرخ خطای انسانها). دانشمندان مایکروسافت میگویند انتظار داشتند رسیدن به سطح برابر با انسان دو یا سه سال طول بکشد اما کمتر از آن طول کشید.

پیشرفتهای آزمایشگاهی حالا در محصولات دنیای واقعی به کار میروند. خودروها با صوت کار میکنند. تعداد کلماتی که میتوان از آنها برای دستور دادن به خودرو استفاده کرد محدود است. این محدودیت دقت را تضمین میکند. میکروفنها نیز عملکرد بهتری در شناسایی گوینده مد نظر در میان دیگران پیدا میکند.

برخی از مشکلات هنوز برطرف نشدهاند. ماشینها صدای بچهها و سالمندان و همچنین افرادی را که در حال راه رفتن هستند بهسختی تشخیص میدهند. صدای پسزمینه هنوز یک نگرانی بزرگ است. اگر صدای زمینه متفاوت با صدای زمینه در دادههای آموزشی باشد، نرمافزار نمیتواند دو زمینه را با هم تطبیق دهد. به همین دلیل است که مایکروسافت محصولی به نام CRIS ارائه کرده تا کاربران بتوانند سیستمهای تشخیص گفتار را بر اساس صدای پسزمینه، کلمات ویژه و سایر جزئیات در محیطهای خاص تنظیم کنند.

اما اینکه کامپیوتر بداند انسان چه گفته صرفاً شروع کار است. تعامل مناسب بین انسان و کامپیوتر به آن شکلی که در داستانهای علمی تخیلی نمایش داده میشود مستلزم این است که ماشینها بتوانند به حرف بیایند و جواب بدهند.

ترجمه ماشینی

ترجمه خودکار باکیفیت جادوییتر از سایر انواع تکنولوژی زبان به نظر میرسد زیرا بسیاری از انسانها تلاش میکنند بیش از یک زبان بدانند چه برسد از زبانی به زبان دیگر ترجمه کنند. این ایده بعد از دهه ۱۹۵۰ پدید آمد و ترجمه کامپیوتری هنوز با عبارت خاص «ترجمه ماشینی» شناخته میشود. این مفهوم به روزهای اول جنگ سرد برمیگردد؛ وقتی دانشمندان آمریکایی تلاش میکردند به کامپیوترها آموزش دهند متون روسی را ترجمه کنند.

دانشمندان از موفقیتهای رمزگشایی در جنگ جهانی دوم الهام گرفته بودند و همین تلاش برای شکستن کدها بود که به توسعه اولین کامپیوترها انجامید. از نظر این افراد، متن روسی در واقع نسخه رمزگذاریشده متن انگلیسی بود و تبدیل آن به انگلیسی صرفاً به معنی رمزگشایی بود.

دانشمندان در آیبیام و دانشگاه جرجتاون جزو آنهایی بودند که فکر میکردند این مشکل بهسرعت حل میشود؛ صرفاً برای شش قانون برنامهنویسی کردند و ۲۵۰ واژه به کامپیوتر معرفی کردند. آنها نتیجه را در ۷ ژانویه ۱۹۵۴ در نیویورک به نمایش درآورند و ۶۰ ترجمه خودکار را با افتخار عرضه کردند. یکی از دانشمندان جرجتاون تحت تاثیر این پیشرفت پیشبینی کرد ترجمه ماشینی در عرض سه تا پنج سال به حقیقت خواهد پیوست.

برعکس، کمی بیش از گذشت یک دهه از کار روی این موضوع، گزارش سال ۱۹۶۶ کمیته جان پیِرس نسبت به نتایج تحقیقات اعلام ناامیدی کرد و از محققان خواست بر اهداف کوچک و دستیاب مانند دیکشنریهای خودکار تمرکز کنند. حمایت دولتی از ترجمه ماشینی به مدت دو دهه متوقف شد. بخش خصوصی نیز پیشرفت محدودی داشت.

دانشمندان به دلیل اتخاذ رویکرد مبتنی بر قوانین به بنبست رسیدند. تصور میکردند اگر قوانین بیشتری به برنامه اضافه کنند، سیستم باهوشتر و ظریفتر میشود. برعکس، احتمال تولید حرفهای بیمعنی به وسیله ماشین افزایش پیدا کرد. نکته دیگر این بود که معنای کلمه صرفاً به تعریف دیکشنری و دستور زبان بستگی ندارد بلکه معنای سایر قسمتهای جمله نیز اهمیت دارند. راهحلش این بود که بهجای نوشتن برنامههای مبتنی بر قوانین، گفتار طبیعی برای آموزش دادن ماشین مورد استفاده قرار بگیرد.

دو دهه بعد، آیبیام به رویکردی رسید که خوشبینی درباره ترجمه ماشینی را احیا کرد. سیستم کاندید آیبیام اولین تلاش جدی برای استفاده از احتمالات آماری بهجای قوانین بود. ترجمه ماشینی مبتنی بر آمار، مانند تشخیص صوت، به دادههای آموزشی برای یادگیری نیاز دارد. کاندید از مباحث مجلس فرانسه و انگلستان به عنوان داده استفاده کرد. رویکرد آماری تضمین میکند کلمه بر اساس واژههای اطرافش ترجمه میشود.

اما کیفیت ترجمه وقتی جهش پیدا کرد که گوگل تصمیم گرفت کل اینترنت را ایندکس کند و از این دادهها برای آموزش دادن ماشینهای ترجمهاش کمک بگیرد. در سال ۲۰۰۷، گوگل موتورش را از سیستم مبتنی بر قانون به سیستم مبتنی بر آمار تغییر داد. برای این کار، حدود هزار میلیارد صفحه وب را جستوجو کرد و متنهایی یافت که ترجمه متنهای دیگری بودند (برای مثال، صفحههایی که طراحیهای یکسانی داشتند ولی از واژگان متفاوتی استفاده کرده بودند). یکی از مهندسان اصلی گوگلترنسلیت میگوید رویکرد ساده استفاده از مقادیر عظیم داده به نظر نویدبخشتر از رویکرد پیچیده با دادههای کمتر بود. آموزش بر اساس متنهای موازی باعث ایجاد «الگوی ترجمه» میشود. این الگو میتواند مجموعهای از ترجمهها در زبان مقصد را تسهیل کند.

کاربران اینترنت بهزودی کشف کردند گوگلترنسلیت بسیار بهتر از مترجمهای آنلاین مبتنی بر قوانین عمل میکند. این نوع سیستمها قرار است به کمک شبکههای عصبی دیجیتالی و یادگیری عمیق ارتقا یابند. گوگل حالا از ترجمه ماشینی مبتنی بر شبکه عصبی استفاده میکند تا برای هشت جفت زبان خدمات ترجمه ارائه دهد.

مترجمهای آینده احتمالاً متخصص کنترل کیفی خواهند بود و تصمیم خواهند گرفت کدام متنها با جزئیات بیشتری به توجه نیاز دارند. این مترجمها خروجی نرمافزار ترجمه ماشینی را ویرایش خواهند کرد. این کار شاید ضروری باشد زیرا کامپیوترها هر اندازه که باهوشتر شوند هنوز نمیتوانند معنای متن را واقعاً درک کنند.

معنا و هوش ماشین:

درباره چه حرف میزنید؟

ماشینها نمیتوانند گفتوگوی مناسبی با انسانها داشته باشند زیرا دنیا را درک نمیکنند.

در سریال «Black Mirror»، زنی جوان نامزدش را در تصادف خودرو از دست میدهد که کاربر فعال رسانههای اجتماعی بود. دوستش پیشنهاد میدهد به او در کنار آمدن با غم کمک کند. به این ترتیب از آرشیو حساب کاربری او برای بازسازی شخصیتش استفاده میکنند. طولی نکشید که سیستم یاد گرفت نامزدش را تقلید کند و واقعیتر به نظر برسد. حالا همیشه مشغول حرف زدن با این سیستم بود.

این داستان به اندازهای که به نظر میرسد عجیب نیست. کامپیوترها همین امروز هم اگر مطالب مناسب دریافت کنند میتوانند پژواکی از زبان انسان به دست دهند. اما کاری که نمیتوانند انجام دهند داشتن یک گفتوگوی حقیقی است. تعامل حقیقی بین انسان و ماشین مستلزم این است که ماشین دنیا را به طور کلی درک کند. در غیر این صورت، کامپیوترها نمیتوانند درباره موضوعات متفاوت حرف بزنند، گفتوگوهای طولانی را دنبال یا غافلگیریها را مدیریت کنند.

البته ماشینهایی که آموزش میبینند کارهای محدودی انجام دهند، نتایج شگفتآوری رقم میزنند. مشهورترین نمونه این ماشینها را میتوان در دستیارهای دیجیتالی غولهای تکنولوژی مشاهده کرد. کاربران میتوانند با زبان طبیعی سوال بپرسند: «دمای لندن چند درجه است؟ هوای بیرون چطور است؟» دستیارها اطلاعات محدودی درباره کاربران دارند؛ مانند محل زندگی یا اعضای خانواده. بنابراین میتوان دستورات شخصی نیز داد: «به همسرم بگو تا ۱۵ دقیقه دیگر میرسم.»

و این دستیارهای دیجیتالی با گذشت زمان ارتقا مییابند. سیری اپل هر هفته دو میلیارد درخواست دریافت میکند. این درخواستها بعد از ناشناس شدن، برای آموزش بیشتر استفاده میشوند؛ برای مثال، اپل میگوید سیری همه سوالهای کاربران درباره نتایج بازیهای ورزشی را میداند. مایکروسافت از گفتارهای محاوره در تعاملهای روزمره استفاده کرده تا به دستیار دیجیتالیاش کورتانا آموزش دهد.

با این اوصاف، پلتفرمهای زبان طبیعی از کجا میدانند مردم چه میخواهند؟ ماشینها نهتنها کلمات مورد استفاده افراد را تشخیص میدهند بلکه گفتار را برای تحلیل دستور زبان و معنی تجزیه میکنند. تجزیهوتحلیل دستور زبان نسبتاً پیشرفته است و بخش نهادینهشدهای از «پردازش زبان طبیعی» محسوب میشود. اما معنی تحت عنوان «درک زبان طبیعی» قرار میگیرد که بسیار دشوارتر است.

عقل سلیم حتی در میان انسانها هم به اندازه کافی رواج ندارد؛ برنامهنویسی برای ایجاد عقل سلیم در کامپیوترها جای خود دارد. فرناندو پرییرا از گوگل دلیلش را توضیح میدهد. تشخیص گفتار خودکار و ترجمه ماشینی یک اصل مشترک دارند: مخازن عظیمی از داده را میتوان برای آموزش ماشینها به کار برد. اما هیچ داده آموزشی برای عقل سلیم وجود ندارد.

دانش درباره جهان موضوعی دیگر است. هوش مصنوعی به شرکتهایی که دادههای زیادی دارند کمک میکند اطلاعات جهان را به پایگاهدادههای تعاملی مانند Google’s Knowledge Graph تبدیل کنند. بخشی از محتوای این گراف در کادر سمت راست صفحه نتایج گوگل برای چهرهها یا مسائل مشهور نمایش داده میشود. برای مثال، گراف گوگل میداند جیکوب برنولی در دانشگاه بازل تحصیل کرده (مانند سایر افرادی که از طریق این گره در گراف به برنولی وصل میشوند) و کتاب «قانون اعداد بزرگ» (گوگل میداند این اسم یک کتاب است) را نوشته است.

سازماندهی اطلاعات به این شیوه برای شرکتی که دادههای زیاد و ظرفیتهای هوش مصنوعی مناسبی دارد دشوار نیست اما وصل کردن اطلاعات به زبان سخت است. گوگل ادعا میکند دستیارش میتواند به این سوال پاسخ دهد: «وقتی تیم رنجرها در سریهای جهانی برنده شدند، چه کسی رئیسجمهور بود؟» اما آقای پرییرا اعتراف میکند این نتیجه آزمایش حسابشده بود. سوال پیچیده دیگر («وقتی ساموئل جانسون دیکشنریاش را نوشت جمعیت لندن چقدر بود؟») دستیار را گیج میکند حتی با اینکه گراف میداند جمعیت لندن در گذشته چقدر بوده و جانسون چه زمانی دیکشنریاش را منتشر کرد. سیستم واتسون آیبیام که در سال ۲۰۱۱ بر دو قهرمان در یک بازی رقابتی غلبه کرد، سازوکار سادهای داشت: محاسبه تعداد زیادی از پاسخهای احتمالی بر اساس کلمات کلیدی و احتمالات نه از طریق درک انسانی سوال.

محاسبهپذیر کردن اطلاعات دنیای واقعی چالشانگیز به نظر میرسد. cortical.io یک استارتآپ مستقر در وین است که ۲۰۰ مقاله ویکیپدیا را به هزاران قطعه اطلاعات کوچک تقسیم و الگوریتم یادگیری ماشین «بدون سرپرست» را روی آن پیاده کرد. قرار بود کامپیوتر صرفاً دنبال کشف الگوها باشد. سپس این الگوها در قالب «ردپای معنایی» روی شبکه ۱۲۸ در ۱۲۸ پیکسلی نمایش داده شدند. تجمع پیکسلها در یک مکان نشانگر شباهت زبانی بود. از این روش میتوان برای رفع ابهام از کلماتی که معانی متعددی دارند استفاده کرد. این توانایی به سیستم زبان طبیعی اجازه میدهد تفاوت بین معناهای یک کلمه خاص را شناسایی کند.

گفتوگوی مناسب بین انسانها و ماشینها را میتوان مجموعهای از چالشهای بههمپیوسته تلقی کرد: تشخیص گفتار، گفتار مصنوعی، تحلیل جمله، تحلیل معنا، درک کاربردی، گفتوگو، عقل سلیم و دانش درباره دنیای واقعی. کل این تکنولوژیها باید با هم کار کنند اما همانطور که میدانیم، کل زنجیره صرفاً به اندازه ضعیفترین حلقهاش قوی است. ضعیفتر بودن برخی از این تکنولوژیها باعث محدود شدن عملکرد کلی میشود.

سختترین کار وصل کردن حلقههای زنجیره به یکدیگر است. دانشمندان نمیدانند مغز انسان چگونه از انواع متفاوت دانش همزمان استفاده میکند. نوشتن برنامهای که کمک کند ماشین چنین عملکردی را تکرار کند هنوز در حال تکامل است.

نگاهی به آینده: شگرد بعدی من

امروز همه باید ماشینهای گویا داشته باشند.

در فیلم WALL-E، بعد از آنکه کل محیط زمین زیستناپذیر شده، همه انسانها روی یک فضاپیما زندگی میکنند. انسانها روی صندلیهای هوشمند معلق حرکت میکنند. ماشینها نیازهای روزمره را برطرف میکنند. به همین دلیل انسانها به چاقی مفرط مبتلا هستند. حتی کاپیتان فضاپیما واقعاً کنترل همهچیز را در اختیار ندارد. خلبان اصلی یک ربات هوشمند و بدخیم به نام اوتو است. اوتو مانند بسیاری از ماشینها در فیلمهای علمیتخیلی در نهایت وسوسه میشود قدرت را در دست بگیرد.

گفتار یک موضوع اساساً انسانی است. بنابراین سخت میتوان تصور کرد ماشینها بتوانند مانند انسان گفتوگو کنند اما ابرباهوش نباشند. و اگر ابرباهوش باشند و عیبهای انسان را نداشته باشند، سخت میتوان تصور کرد که نخواهند نهتنها خودشان بلکه کل بشریت را تحت کنترل درآورند. حتی در آینده خوشبینانهای مانند WALL-E که در آن ماشینها کارها را انجام میدهند، میتوان دید که غیابِ چالش به مردم آسیب میزند.

خوشبختانه کارهایی که ماشینهای گویا از لیست کارهای انسانها برمیدارند از آن کارهایی هستند که بسیاری از مردم با کمال میل واگذارشان میکنند. ماشینها به طور روزافزون قادرند کارهای سخت اما تعریفشده را انجام دهند. بهزودی صرفاً کافی است کاربرها ماشینها را احضار کنند و با استفاده از دستور صوتی با زبان طبیعی از آنها درخواست کنند. روزی روزگاری، فقط آن بچه خاص خانواده میدانست چطور باید با کامپیوتر یا دوربین فیلمبرداری کار کرد. بعداً رابطهای گرافیکی (آیکون و ماوس) و صفحات لمسی این نوع فناوری را در اختیار همه قرار دادند. فرانک چن از اندرسن هوروویتز، شرکت سرمایهگذاری خطرپذیر، رابطهای زبان طبیعی بین انسانها و ماشینها را گامی دیگر در مسیر عمومیت بخشیدن به اطلاعات و سرویسها مینامد. او میگوید سیلیکونولی از عصر طلایی تکنولوژیهای هوش مصنوعی سود میبرد. درست همانطور که در اوایل دهه ۱۹۹۰ شرکتها آنلاین میشدند و وبسایت میساختند بدون اینکه دقیقاً بدانند چرا، امروز همه به دنبال زبان طبیعی هستند. چن اضافه میکند: «ما در زمینه صوت در سال ۱۹۹۴ به سر میبریم.»

سال ۱۹۹۵ بهزودی فرا میرسد. معنایش این نیست که مردم با کامپیوترهایشان فقط با حرف زدن ارتباط برقرار خواهند کرد. وبسایتها تلفن را منسوخ نکردند و دستگاههای موبایل کامپیوترهای دسکتاپ را از رده خارج نکردند. بر همین منوال، مردم هنگام تعامل با ماشینهایشان همیشه میتوانند بین صوت و متن انتخاب کنند.

مردم حتی برای معاشرت هم سراغ ماشینها میروند. Xiaoice مایکروسافت یک چتبات است که در چین راهاندازی شده و یاد میگیرد پاسخهایی بدهد که گفتوگو را تا حد ممکن طول میدهند. هیچکس تصور نمیکند این انسان است اما هوش مصنوعی با روشهای غیرمنتظرهای زبان کاربران را باز میکند. Jibo، یک «ربات اجتماعی» جدید، میخواهد برای بچهها داستان بگوید، به حفظ رابطه با وابستگان دور کمک کند و کارهایی از این دست.

جوامع کوچک از نظر زبانی نیز میتوانند از این تکنولوژی سود ببرند. کامپیوترهای متصل به شبکه میتوانند اثر «برنده همه پاداشها را میگیرد» داشته باشند: اگر نرمافزار و محتوای خوب زیادی به زبانهای انگلیسی و چینی وجود داشته باشد، زبانهای جوامع کوچکتر ممکن است ارزش آنلاین کمتری داشته باشند. اگر این زبانها واقعاً کوچک باشند، بقایشان ممکن است در معرض خطر باشد. اما رالس پرلین از انجمن زبانهای در معرض خطر توضیح میدهد، نرمافزار جدید به محققان اجازه میدهد زبانهای کوچک را سریعتر از همیشه مستند کنند. اگر مقدار داده کافی باشد، احتمال توسعه منابع (از تشخیص صوت تا رابطهای نرمافزاری) برای زبانهای کوچکتر افزایش مییابد. غولهای سیلیکونولی همین حالا هم سرویسهایشان را به چند زبان محلی کردهاند. شبکههای عصبی و سایر نرمافزارها این امکان را به وجود میآورند که نسخههای جدیدتر سرویسها سریعتر و کارآمدتر از همیشه تولید شوند.

دو نقطهضعف در گسترش تکنولوژی زبان طبیعی وجود دارد: پیامدها برای حریم و اختلال در بسیاری از مشاغل.

دستگاهها بیش از پیش در حال گوش دادناند. دستیارهای دیجیتالی مانند الکسا، کورتانا، سیری و گوگل اسیستانت برنامهریزی شدهاند تا برای فعال شدن منتظر دستور باشند؛ مانند «هی سیری» یا «اوکی گوگل». اما وقتی اجازه میدهیم میکروفنها همیشه در جیب افراد و خانههایشان فعال باشند، انتظارهای سنتی از حریم را نقض میکنیم. همین موضوع در مورد نرمافزارهای زبانیای نیز صدق میکند که روی صوت، واژگان، نوشتهها و عادتهای یک کاربر واحد آموزش میبینند. علاوه بر این، سرویسهای مکانمحور بسیاری از شرکتهای بزرگ مشغول حدس زدن نیازها و خواستههای کاربراناند.

موضوع نگرانکننده دیگر در مورد تکنولوژی زبان طبیعی به مشاغل برمیگردد. مشاغل روزمره با اتوماسیون مواجهاند. پشتیبانی از مشتری یکی از مثالهای خوب است. وقتی مردم با شرکتی تماس میگیرند تا درخواست کمک کنند، برخورد اول معمولاً بسیار تمرینشده است. کارمند شرکت هویت مشتری را تایید و سپس از درخت تصمیمگیری پیروی میکند. تکنولوژی زبان حالا به اندازه کافی بالغ شده و میتواند بسیاری از این کارها را انجام دهد.

انسانها در طول یک دوره طولانی تحول همچنان لازم خواهند بود اما کارهایشان کمتر روزمره خواهد بود. نوآنس که سیستمهای کمک آنلاین تلفنی عرضه میکند، در زمینه بیومتری صوتی سختگیر است (مشتریها خودشان را با گفتن «صدای من رمز عبور من است» اثبات میکنند). برت برانک، یکی از مدیران ارشد نوآنس، میگوید استفاده از حدود ۲۰۰ معیار برای شناسایی گوینده احتمالاً امنتر از اثرانگشت است.

کل این بحث سرانجام این سوال را به ذهن متبادر میکند که انسان بودن چه معنایی دارد. زبان اغلب منحصربهفردترین ویژگی بشر تلقی میشود. محققان هوش مصنوعی تاکید میکنند که ماشینها مثل مردم فکر نمیکنند اما اگر مثل انسانها گوش بدهند و حرف بزنند، آنها را چه میتوان نامید؟ اگر انسانها به ماشینهای قویتر بیشتر آموزش دهند تا از زبان استفاده کنند، مرز بین انسان و ماشین که زمانی برجسته بود کمرنگ خواهد شد.

منبع: اکونومیست